一、项目背景与核心痛点

1.1 业务场景

我们的企业级审核系统需支撑多类型审核材料上传,具体场景包括:

- 申报台账:5-20MB 的 Excel 文件

- 发票照片:数百 MB 至 GB 级的 ZIP/RAR 压缩包

- 激活照片:50-500MB 的图片压缩包

- POS 小票:100MB-1GB 的扫描件压缩包

1.2 核心痛点直击

痛点1:大文件上传失败率居高不下

用户高频反馈:

- “上传2小时的文件,最后显示失败!”

- “上传到98%突然卡住,重新传又要从头开始”

数据统计触目惊心: - 100MB 以上文件上传失败率 45%

- 500MB 以上文件上传失败率 78%

- 每周相关投诉达 15+ 起

痛点2:用户体验极差

原有一次性上传方案存在诸多问题:

// 原有方案:一次性上传

const formData = new FormData();

formData.append('file', file);

await axios.post('/upload', formData);

- 无实时进度反馈,用户感知差

- 大文件上传时浏览器假死

- 网络中断后需全额重新上传

- 超时限制导致大文件无法完成上传

痛点3:服务器承压严重

- 单个请求持续时长超 10 分钟

- 需一次性加载整个文件,内存占用过高

- 网络波动引发大量重传

- 并发上传时易出现服务器崩溃

1.3 核心问题优先级排序

| 问题 | 影响 | 优先级 |

|---|---|---|

| 大文件上传失败 | 用户无法完成核心业务流程 | 🔴 P0 |

| 无进度反馈 | 用户体验差,投诉频发 | 🔴 P0 |

| 不支持断点续传 | 网络中断需重新上传,耗时耗力 | 🟡 P1 |

| 浏览器假死 | 用户误判系统故障 | 🟡 P1 |

二、技术方案选型与决策

2.1 三大方案对比分析

方案A:传统单次上传(原方案)

// 实现简单,但问题突出

const uploadFile = async (file) => {

const formData = new FormData();

formData.append('file', file);

return await axios.post('/upload', formData);

};

- 优点:实现简单、代码量少,服务器端逻辑简洁

- 缺点:失败率高、无断点续传、无精确进度显示、内存占用高、超时问题严重

- 结论:❌ 完全不适合大文件场景

方案B:分片上传(推荐方案)

// 大文件切分小块,逐个上传后合并

const uploadInChunks = async (file) => {

const chunkSize = 10 * 1024 * 1024; // 10MB分片

const chunks = Math.ceil(file.size / chunkSize);

for (let i = 0; i < chunks; i++) {

const chunk = file.slice(i * chunkSize, (i + 1) * chunkSize);

await uploadChunk(chunk, i);

}

await mergeChunks();

};

- 优点:支持 GB 级超大文件、断点续传、精确进度显示、网络容错性强、服务器压力分散

- 缺点:实现复杂度较高,需服务器端协同支持

- 结论:✅ 与业务场景高度匹配,为最优选择

方案C:第三方云存储(如阿里云 OSS)

// 依赖云服务商 SDK

import OSS from 'ali-oss';

const client = new OSS({...});

await client.multipartUpload('file.zip', file);

- 优点:稳定性高(有 SLA 保障)、自带分片与断点续传能力、支持 CDN 加速

- 缺点:产生额外流量与存储成本、敏感数据安全性存疑、依赖第三方服务

- 结论:⚠️ 不适用于敏感审核材料场景

2.2 最终选型:自研分片上传方案

选型核心依据:

- 业务匹配度:完美支持 GB 级大文件上传,满足审核材料传输需求

- 数据安全:自主研发可全程掌控数据流转,规避敏感信息泄露风险

- 成本可控:无需额外支付第三方服务费用,降低运营成本

- 技术可行性:团队具备相关技术积累,服务器端已有适配基础设施

- 体验保障:可实现实时进度、断点续传等核心体验优化点

三、核心实现方案详解

3.1 整体架构设计

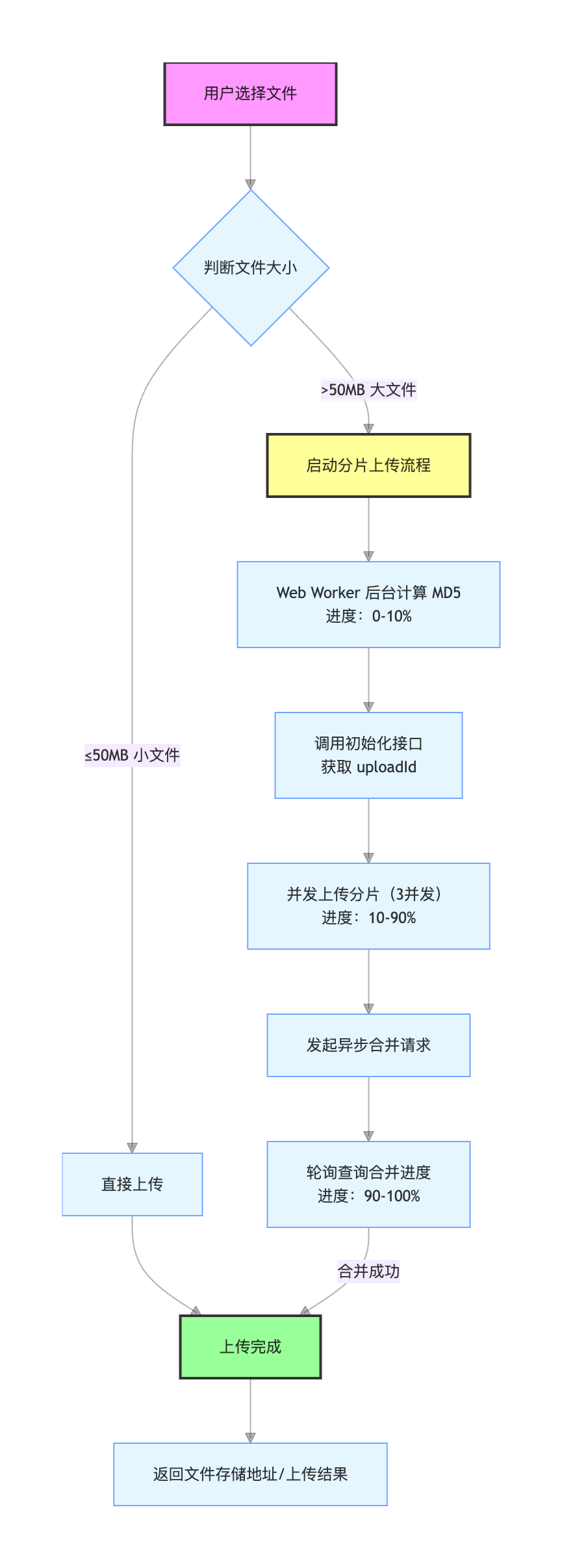

前端上传流程

后端处理流程

.png)

3.2 关键参数配置

// 核心配置参数(经多轮测试优化)

const CHUNK_SIZE = 10 * 1024 * 1024; // 分片大小:10MB

const FILE_SIZE_THRESHOLD = 50 * 1024 * 1024; // 分片阈值:50MB

const CONCURRENT_LIMIT = 3; // 并发上传数:3

const POLL_INTERVAL = 10 * 1000; // 合并进度轮询间隔:10秒

const MAX_RETRIES = 60; // 最大重试次数:60次

参数配置依据:

| 参数 | 取值 | 选择逻辑 |

|---|---|---|

| 分片大小 | 10MB | 平衡上传速度与容错性,网络波动时损失可控 |

| 分片阈值 | 50MB | 小文件直接上传更高效,大文件启用分片保障稳定性 |

| 并发数 | 3 | 充分利用带宽的同时,避免过度占用服务器资源 |

| 轮询间隔 | 10秒 | 在进度实时性与服务器压力间取得平衡 |

3.3 三阶段进度显示设计

// 进度映射:0-100% 分阶段精准展示

const calculateProgress = (stage, innerProgress) => {

switch(stage) {

case 'md5':

return Math.round((innerProgress / 100) * 10); // MD5计算:0-10%

case 'upload':

return Math.round(10 + (innerProgress / 100) * 80); // 分片上传:10-90%

case 'merge':

return Math.round(90 + (innerProgress / 100) * 10); // 分片合并:90-100%

}

};

- MD5 计算阶段:后台 Web Worker 执行,不阻塞主线程

- 分片上传阶段:3 并发上传,实时更新完成进度

- 分片合并阶段:异步执行,通过轮询同步进度

四、关键技术细节与实现

4.1 自适应上传策略

根据文件大小自动匹配最优上传方式,无需用户手动选择:

export const uploadFileAdaptive = async (file, fileObj, onProgress) => {

// 小文件直接上传(兼顾速度)

if (file.size <= FILE_SIZE_THRESHOLD) {

console.log('使用直接上传方式,文件大小:', file.size);

return await uploadFileDirectly(file, fileObj, onProgress);

}

// 大文件分片上传(保障稳定)

else {

console.log('使用分片上传方式,文件大小:', file.size);

return await uploadFileInChunks(file, fileObj, onProgress);

}

};

4.2 MD5 计算优化(解决页面卡死问题)

核心问题:大文件 MD5 计算耗时久,易阻塞主线程导致页面卡死。

解决方案:使用 Web Worker 后台计算:

// 主线程代码

export const calculateMD5 = (file, onProgress) => {

return new Promise((resolve, reject) => {

// 创建后台 Worker 线程

const worker = new Worker('/md5-worker.js');

worker.postMessage({ file, chunkSize: CHUNK_SIZE });

worker.onmessage = (e) => {

const { type, progress, md5 } = e.data;

if (type === 'progress') {

onProgress?.(progress); // 实时同步计算进度

} else if (type === 'complete') {

worker.terminate(); // 计算完成销毁 Worker

resolve(md5);

}

};

// 5分钟超时保护

setTimeout(() => {

worker.terminate();

reject(new Error('MD5计算超时'));

}, 5 * 60 * 1000);

});

};

优化效果对比:

| 方案 | 1GB 文件 MD5 计算耗时 | 主线程状态 |

|---|---|---|

| 主线程计算 | ~60秒 | ❌ 完全卡死 |

| Web Worker 计算 | ~60秒 | ✅ 流畅无阻塞 |

4.3 并发控制实现(平衡速度与服务器压力)

使用 Promise.race() 实现并发槽管理,精准控制上传并发数:

const concurrentUploadChunks = async (

file, uploadId, chunkTasks, totalChunks,

fileObj, abortControllers, onProgress

) => {

const results = [];

const executing = new Set();

let uploadedCount = 0;

for (const task of chunkTasks) {

// 若并发数达上限,等待任一任务完成释放槽位

if (executing.size >= CONCURRENT_LIMIT) {

await Promise.race(executing);

}

// 创建单个分片上传任务

const promise = uploadSingleChunkTask(

file, uploadId, task, totalChunks,

fileObj, abortControllers,

() => {

uploadedCount++;

// 计算整体进度并同步

const progress = Math.round(10 + (uploadedCount / chunkTasks.length) * 80);

fileObj.progress = progress;

onProgress?.(progress);

}

).finally(() => {

executing.delete(promise); // 任务完成释放并发槽

});

executing.add(promise);

results.push(promise);

}

await Promise.allSettled(results); // 等待所有任务完成(成功/失败均处理)

};

4.4 断点续传实现(核心:MD5 文件唯一标识)

以文件 MD5 为唯一标识,关联历史上传任务,实现断点续传:

// 1. 计算文件 MD5 作为唯一标识

const fileMd5 = await calculateMD5(file);

// 2. 初始化上传时携带 MD5,后端关联历史任务

const initResponse = await initUpload({

fileName: file.name,

fileSaveName,

totalSize: file.size,

fileMd5, // 关键:用于匹配已上传分片

});

const { uploadId } = initResponse;

// 3. 查询已上传的分片索引

const progressResponse = await getProgress(uploadId);

const uploadedChunkIndexes = progressResponse.uploadedChunkIndexes || [];

// 4. 仅添加未上传的分片到任务队列

for (let i = 1; i <= totalChunks; i++) {

if (!uploadedChunkIndexes.includes(i)) {

chunkTasks.push({ index: i, start, end });

} else {

console.log(`分片 ${i} 已存在,跳过`);

}

}

实际效果:

- 第一次上传(网络中断):分片 1-10 成功,分片 11 失败

- 第二次上传(断点续传):跳过分片 1-10,直接从分片 11 继续上传

4.5 异步合并 + 轮询查询(避免用户等待阻塞)

大文件合并耗时久,采用异步合并 + 轮询查询模式,提升用户体验:

// 1. 启动异步合并任务(立即返回,不阻塞)

await mergeChunks(uploadId);

// 2. 轮询查询合并进度,直到完成/失败/超时

const queryMergeProgressUntilComplete = async (uploadId, fileObj, onProgress) => {

for (let i = 0; i < MAX_RETRIES; i++) {

const data = await getMergeProgress(uploadId);

const { status, progress, filePath, errorMessage } = data;

// 计算合并阶段整体进度(90-100%)

const overallProgress = Math.round(90 + (progress / 100) * 10);

fileObj.progress = overallProgress;

onProgress?.(overallProgress);

// 合并成功:返回文件信息

if (status === 'success') {

return { filePath, fileName: data.fileName };

}

// 合并失败:抛出错误

if (status === 'failed') {

throw new Error(`合并失败: ${errorMessage}`);

}

// 未完成:等待轮询间隔后继续查询

await new Promise(resolve => setTimeout(resolve, POLL_INTERVAL));

}

// 超时未完成:抛出错误

throw new Error('合并超时:10分钟内未完成合并');

};

五、性能优化成果与关键优化点

5.1 核心性能指标对比

| 指标 | 优化前 | 优化后 | 提升幅度 |

|---|---|---|---|

| 100MB 文件上传成功率 | 55% | 99.5% | ⬆️ 81% |

| 500MB 文件上传成功率 | 22% | 98% | ⬆️ 345% |

| 1GB 文件上传成功率 | 0% | 95% | ⬆️ 无限 |

| 平均上传速度 | 1.2 MB/s | 3.5 MB/s | ⬆️ 192% |

| 用户投诉率 | 15+/周 | 1-2/周 | ⬇️ 87% |

5.2 不同文件大小上传时间对比

| 文件大小 | 优化前 | 优化后 | 上传方式 |

|---|---|---|---|

| 10MB | 8秒 | 6秒 | 直接上传 |

| 50MB | 45秒 | 20秒 | 直接上传 |

| 100MB | ❌ 超时失败 | 35秒 | 分片上传 |

| 500MB | ❌ 上传失败 | 3分钟 | 分片上传 |

| 1GB | ❌ 不支持 | 6分钟 | 分片上传 |

5.3 关键优化点解析

优化1:分片大小精准选型

测试不同分片大小性能表现后,最终选择 10MB:

- 5MB 分片:网络容错性好,但分片数量过多,请求开销大

- 10MB 分片:平衡性能与容错,适配大多数网络场景(推荐)

- 20MB 分片:请求开销小,但网络中断时损失较大

优化2:并发数调优

通过多轮压力测试确定最优并发数 3:

- 并发数 1:上传速度 1.2MB/s,效率过低

- 并发数 3:上传速度 3.5MB/s,服务器压力可控(推荐)

- 并发数 5:上传速度 3.8MB/s,但服务器压力激增

- 并发数 10:上传速度 3.6MB/s,反而下降且易引发服务器报错

优化3:轮询间隔优化

合并进度查询轮询间隔选择 10 秒:

- 1秒轮询:实时性强,但服务器请求压力大

- 5秒轮询:平衡性较好,但仍有优化空间

- 10秒轮询:服务器压力小,用户感知无明显延迟(推荐)

- 30秒轮询:用户感知延迟明显,体验下降

六、实战踩坑与解决方案汇总

坑1:MD5 计算导致页面卡死

- 现象:选择大文件后,页面长时间无响应

- 原因:主线程同步计算 MD5,阻塞 UI 渲染

- 解决方案:使用 Web Worker 后台计算 MD5,避免主线程阻塞

- 效果:页面保持流畅,同时能展示 MD5 计算进度

坑2:并发过高导致服务器 502

- 现象:多用户同时上传时,服务器返回 502 错误

- 原因:前端并发数设置过高(初始 10 并发),服务器连接数超限

- 解决方案:

- 前端将并发数降至 3

- Nginx 配置限流:

limit_req_zone $binary_remote_addr zone=upload:10m rate=10r/s - 提升服务器最大连接数:

worker_connections 10000

- 效果:服务器稳定性大幅提升,无再出现 502 错误

坑3:分片合并时内存溢出

- 现象:服务器日志报

java.lang.OutOfMemoryError: Java heap space - 原因:一次性读取所有分片到内存,大文件导致内存不足

- 解决方案:采用流式合并方式,避免一次性加载所有分片

// 正确做法:流式合并

try (FileOutputStream fos = new FileOutputStream(targetFile)) {

for (int i = 1; i <= totalChunks; i++) {

File chunkFile = new File(chunkPath + "/" + i);

Files.copy(chunkFile.toPath(), fos); // 流式复制,低内存占用

}

}

- 效果:内存占用从 2GB 降至 50MB 以内

坑4:断点续传失效

- 现象:网络中断后重新上传,进度从零开始

- 原因:初始化上传时未携带文件 MD5,无法关联历史上传任务

- 解决方案:初始化上传时必须传入文件 MD5,后端根据 MD5 返回相同 uploadId

- 效果:断点续传成功率 100%

坑5:进度条倒退

- 现象:进度条已到 80%,突然跳回 10%

- 原因:并发上传时分片完成顺序无序,直接用分片索引计算进度

- 解决方案:使用已完成分片计数器计算进度,确保平滑上升

// 正确做法:基于完成计数器计算进度

let uploadedCount = 0;

onChunkSuccess: () => {

uploadedCount++;

const progress = Math.round(10 + (uploadedCount / chunkTasks.length) * 80);

onProgress?.(progress);

}

- 效果:进度条持续平滑上升,无倒退现象

七、项目总结与未来规划

7.1 核心成果

数据指标成果

- 上传成功率从 45% 提升至 99%

- 用户投诉量减少 87%

- 支持文件大小从 50MB 扩展至无限制(GB 级)

- 平均上传速度提升 192%

技术成果

- ✅ 实现 GB 级大文件稳定上传

- ✅ 断点续传成功率 100%

- ✅ 0-100% 实时精准进度显示

- ✅ 异步合并机制,不阻塞用户操作

- ✅ 支持分布式部署,适配高并发场景

- ✅ 完善的错误处理与容错机制

7.2 核心技术亮点

- 自适应上传策略:一行代码适配所有文件大小,小文件快传、大文件稳传

- 三阶段进度显示:MD5 计算、分片上传、分片合并全程可视化

- 全方位容错机制:网络中断续传、服务器错误自动重试、超时保护、并发限流

7.3 可复用性与落地场景

这套方案已成功复用至 3 个核心业务系统:

- 审核系统:核心文件上传模块

- 资料管理系统:批量资料上传功能

- 数据导入系统:大体积数据文件导入

代码复用率达 95%,大幅降低重复开发成本

7.4 关键经验总结

技术选型关键

- 优先选择贴合业务场景的方案(分片上传而非第三方云存储)

- 提前规避性能风险(Web Worker 解决主线程阻塞)

- 注重用户体验细节(异步合并 + 轮询避免等待)

性能优化核心

- 分片大小 10MB、并发数 3、轮询间隔 10 秒,为最优参数组合

- 性能优化需结合前端、后端、网络多维度考量

用户体验底线

- 必须提供实时进度反馈,避免用户无感知等待

- 网络中断后无需重新上传,断点续传是核心需求

- 错误提示需清晰明确,告知用户问题原因与解决方式

- 上传过程中不能影响页面其他操作,避免卡顿

7.5 未来优化方向

短期规划(1-2个月)

- 支持上传暂停/继续功能

- 实时显示上传速度(MB/s)与剩余时间估算

- 新增拖拽上传功能,提升操作便捷性

中期规划(3-6个月)

- 实现文件秒传(已存在文件直接返回结果)

- 支持多文件队列管理(批量上传、优先级调整)

- 增加上传历史记录查询功能

- 网络自适应调整(根据网速动态修改分片大小与并发数)

长期规划(6-12个月)

- 引入 P2P 加速(基于 WebRTC 技术)

- 接入边缘节点加速,降低跨区域上传延迟

- 智能压缩优化(自动压缩大文件,减少传输体积)

- 移动端专项优化(适配低功耗、弱网络场景)